سحب بيانات موقع و عمل تحليل للبيانات التى تم سحبها (Web Scraping)

تفاصيل العمل

لو محتاج تجمع بيانات من موقع معيّن، أو حتى من مواقع كتير، من غير ما تدخل تنسخ البيانات يدويًا، هنا بييجي دور Web Scraping.

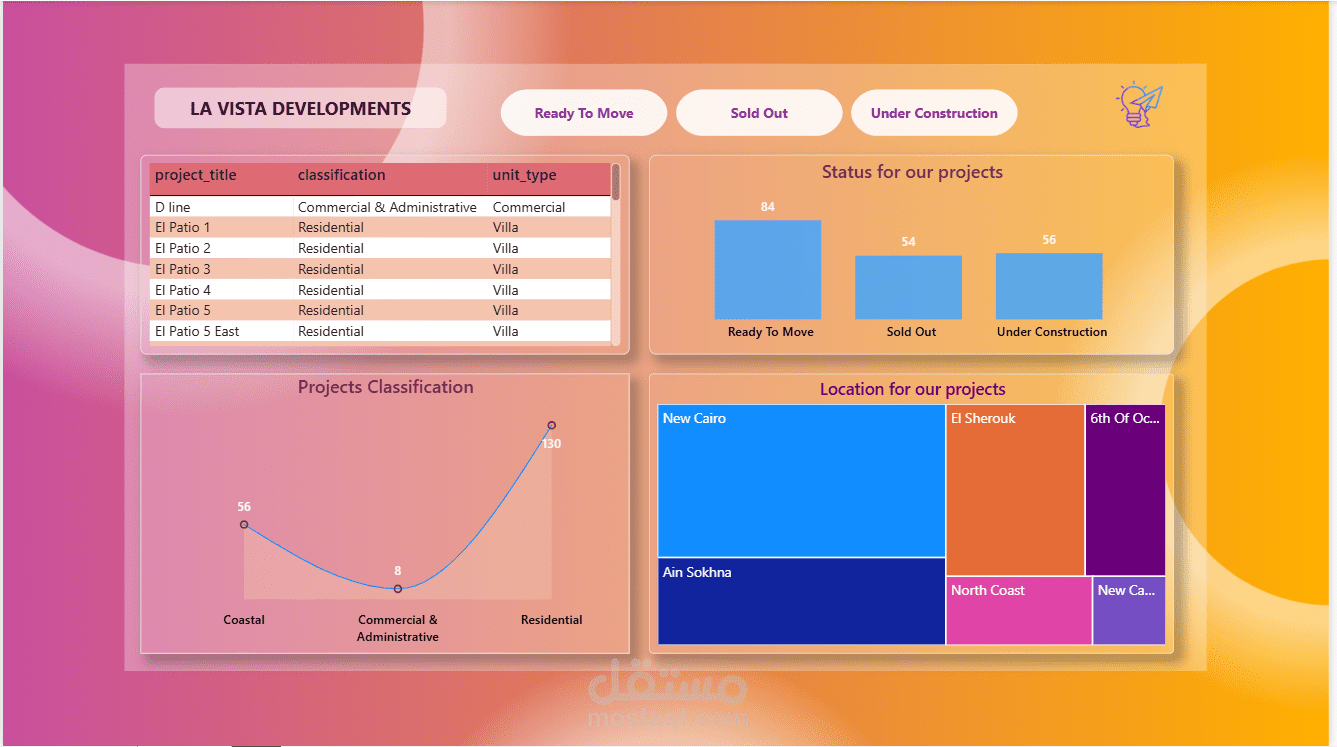

في المشروع ده قمت بسحب بيانات من موقع Lavista Development باستخدام Python Web Scraping، وبعد كده نفذت عليها:

ETL Process

Data Cleaning

تحميل البيانات على Power BI

عمل Data Analysis

تصميم Automated Dashboard

الميزة الأساسية في المشروع إن الـ Dashboard بتتحدّث تلقائيًا؛

بمجرد ما تعمل Refresh في Power BI:

الداتا بتتحدّث

التحليل بيتحدّث

والنتايج بتتغير حسب أحدث بيانات

تخيّل الميكس ده:

Web Scraping + Python + Power BI

النتيجة: Amazing Data Analysis

أي نوع بيانات يخطر على بالك تقدر تجمعه أوتوماتيك و تنظّفه و تحلّله وتطلع منه Insights قوية

وتعرضه في Dashboard ديناميكية بتتحدّث بضغطة زر

باختصار:

داتا دايناميك

تحليل احترافي

وقرارات أذكى