جمع 140 ألف اعلان وظيفي من جدارات بستعمال لغة البرمجة Python

تفاصيل العمل

الهدف : جمع بيانات الاعلانات الوظيفيه في ارشيف الوظائف من منصة جدرات .

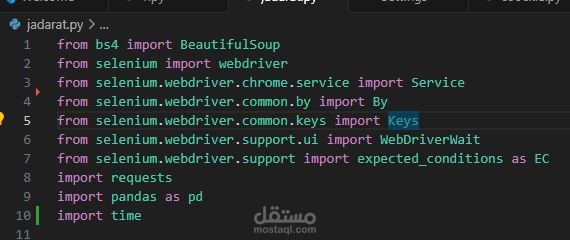

في هذا المشروع استعملت الكثير من مكتبات Python لكن اهم المكتبات هم BeautifulSoup و Selenium و Pandas لجمع و تنظيف و تخزين البيانات .

البرنامج عباره عن حلقة برمجية (Loop ) تعمل كالتالي :

1- في بداية الحلقة يعمل Selenium لمحكات تصفح الموقع

2- بعد الدخول للموقع و تحميل البيانات يتم سحب بيانات HTML بستعمل BeautifulSoup

3- بعد سحب بيانات HTML يتم تنظيف البيانات بستعمل BeautifulSoup

4- ثم تحفظ البيانات في dataframe في Pandas

تتكرر هذه العمليات بحلقة مستمره تمر على 7000 صفحه

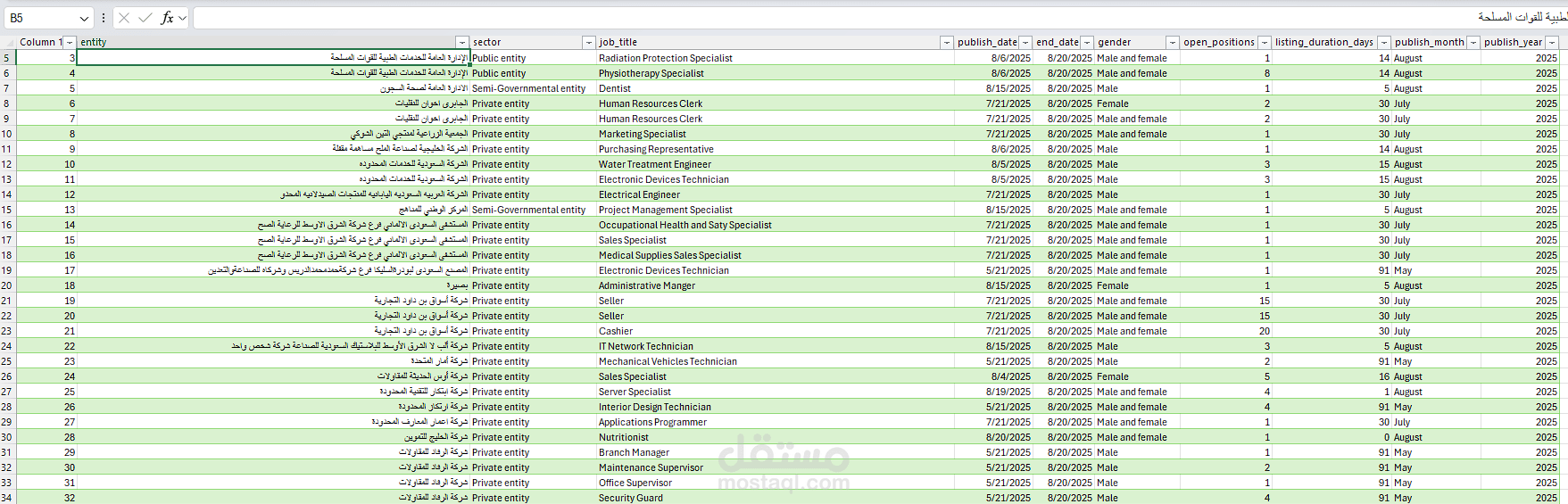

لتجمع 140 الف اعلان وظيفي في ملف csv

الاعلانات تحتوي على ( الجهة, نوع الجهة , المسماء الوظيفي , تاريخ النشر , تاريخ الانتهاء , الجنس ,عدد الشواغر ) .

بعد جمع البيانات استعملت Pandas لترتيب البيانات و أضفت الاعمده التاليه ( تاريخ النشر الميلادي , تاريخ الانتهاء الميلادي , سنة النشر , شهر النشر , يوم النشر , مدة الاعلان الوظيفي بالايام )