بناء Data Pipeline باستخدام Apache Airflow لأتمتة عمليات ETL

تفاصيل العمل

هذا المشروع يهدف إلى تصميم وتنفيذ بايبلاين بيانات (Data Pipeline) باستخدام Apache Airflow لإدارة وجدولة عمليات ETL.

يتضمن المشروع:

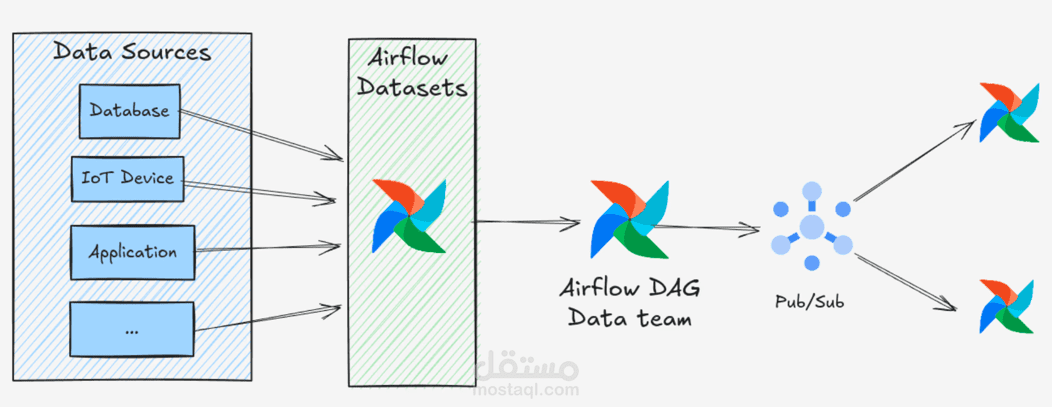

Ingestion: جمع البيانات من مصادر مختلفة (قواعد بيانات، ملفات CSV/Parquet، أو APIs).

Processing: تنفيذ خطوات التحويل (Cleaning, Transformation, Aggregation) باستخدام Python و SQL.

Orchestration: استخدام Airflow DAGs لأتمتة وجدولة تدفق البيانات.

Storage: تخزين البيانات في قاعدة بيانات أو Data Warehouse بعد المعالجة.

Visualization: تمكين أدوات التقارير مثل Power BI أو Tableau من استهلاك البيانات النهائية.

الهدف من المشروع هو أتمتة خط سير البيانات بالكامل وجعله أكثر كفاءة وقابلية للتوسع، مع إمكانية المراقبة والتعامل مع الأخطاء.